pc网站 手机网站 微网站网站新增一个域名备案

2023,中国消费市场出现温和复苏态势,在不确定市场环境下,大众消费商家如何用好科学营销手段,实现确定性增长?如何紧跟平台趋势,把握生意增长先机?

为了给商家持续提供前沿适配的营销方法、解决实际生意卡点,巨量引擎大众消费业务中心联动巨量学及内外部一线讲师,设计搭建了维度多样的商家培育课程体系,从理论到实操,从新手到进阶,提供了海量学习资源,助力商家们的生意增长与能力提升。

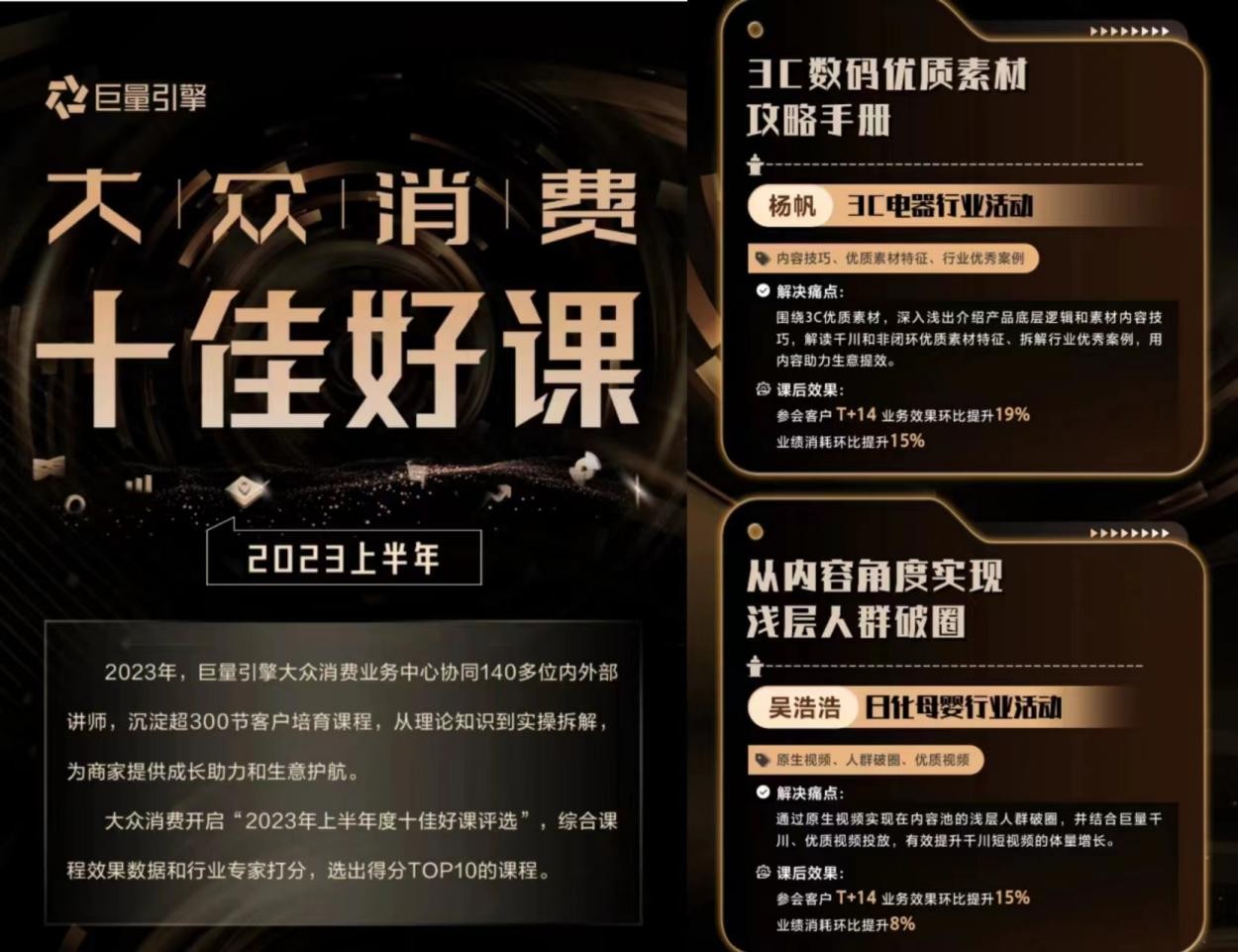

9月8日,巨量引擎大众消费业务中心举办2023半年度讲师大会,并发布大众消费“十佳好课”榜单,同时,来自大众消费行业策略、行业运营、商业产品的代表分享了平台最新策略和产品政策更新。

如何评价课程内容与商家需求的契合度?如何衡量课程对推动商家生意落实有效?大众消费业务中心开启“2023年上半年度十佳好课评选”,评选历时一个月,共经历三轮。在上半年所有课程中,以课程热度、满意度评分、商家学后生意效果等客观数据标准综合评定TOP20课程入围初选;复评邀请内外部各5位资深讲师,组成专家评审团,对20节入围课程从内容质量、行业视角、课件制作等维度进行专业打分;最终合计客观数据分和专家打分,遴选TOP10课程。

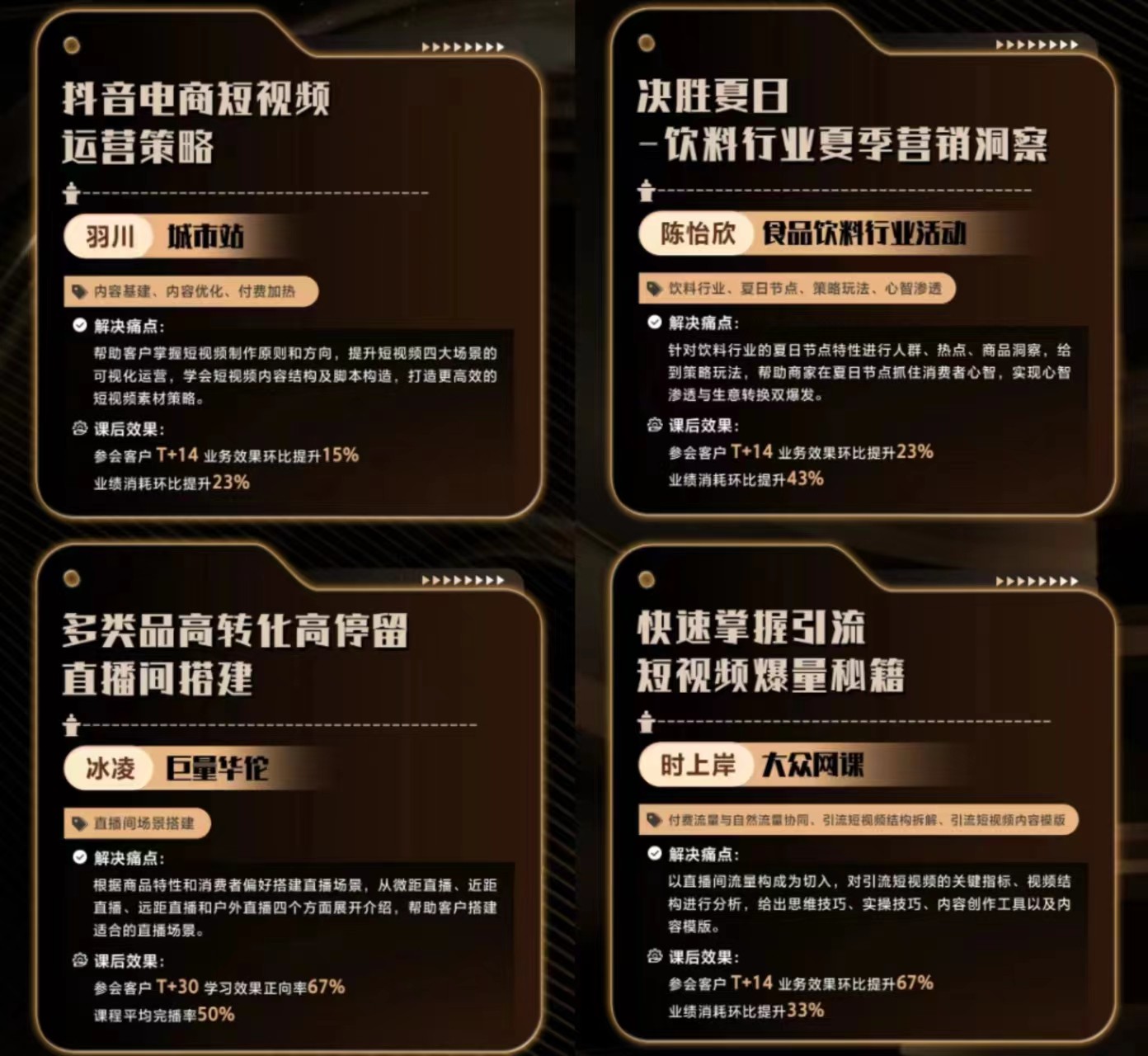

在榜单中,有针对美妆个护、服装配饰、日化母婴、食品饮料、3C电器等大众消费五大行业的垂直课程,也有来自大众网课、城市站、巨量华佗等全行业项目的通识课程,其内容涵盖了直播、短视频、人群运营、货品运营等经营策略,以及巨量千川、巨量云图、巨量星图等产品进阶攻略。

据介绍,2023年上半年,巨量引擎大众消费协同140多位内外部讲师,研发了超过300节客户培育课程,其中外部视角原创课程超过160节,从行业前瞻、理论知识到实操拆解,为商家解决疑难杂症,还实现了系统智能诊断推课及效果回扫,助力商家长效增长。

巨量引擎大众消费也提出,将围绕“经营”和“度量”两大维度,助力和培育更多“好品牌、好内容、好商品、好服务”的商家经营增长。通过商业产品帮助企业挖掘和打造潜力爆品;深入生活消费场景,为消费者提供出色的体验,帮助企业提供好服务;并且以IP、短剧、星图达人合作,助力品牌产出有吸引力的好内容,进而成就好品牌。