做网站上数字快速增加wordpress个人博客建站

最近很多朋友问我电视盒子的相关问题,就目前来说,电视盒子的地位依然是不可取代的。我近来要发布的测评内容是哪个牌子的电视盒子好用,耗时两周进行对比后整理了电视盒子排名,看看哪些电视盒子是最值得入手的吧。

NO.1——泰捷新品WEBOX 40S电视盒子

▶超强配置,无广告看片

泰捷WEBOX在业内一直都有“一台顶三台”的名号,原因在于盒子的流畅度、使用寿命等都要比其他同价位高出不少。由于泰捷拥有长达十年的视频经验积累,而且这十年以来也一直潜心研究视频技术,由此也斩获了很多国际大奖!

硬件配置

泰捷WEBOX 40S的配置硬件非常强悍,比如芯片是目前最高端的热门瑞芯微芯片,视频解码技术一流,保证视频的流畅度以及性能稳定的发挥。内存配置方面搭载了足足2G+64G的超大内存,整体的配置、跑分要比同价位的其他牌子高很多,从根源解决了卡顿问题。泰捷在扩展性能上也不会忽视,不仅支持杜比音效,还有WIFI6、千兆网口等!

视频体验:

“六大核心技术”是泰捷这些年自主研发出的专利技术,目的是为了带来更极致的观影体验,也是泰捷能成为业内巨头的原因。这款电视盒子全程4K高清播放,期间随意拖动进度条也没有出现卡顿。而且现在大多数电视盒子的通病就是植入广告太多,但是泰捷旗下的电视盒子从开机到播放结束全程没有广告,算得上是业内的一股清流!

操作系统:

安卓系统用久之后,一般都会越来越卡,而泰捷WEBOX自主研发的“零极”系统有很多优势,很多用户选择它也是看重其系统效率,迭代将近十年,在性能、速度、流畅度方面都要更好。为了提高速度,系统采用三层净化,为了更稳定流畅的视频体验,团队花费2年研发出了视频缓冲增强技术等。这样保证了泰捷盒子长时间运行下,速度和流畅度都非常棒。

工艺水准:

泰捷在工艺水准上是在业内出了名的高,曾有工厂内部人员爆料,有着多达60余项高强度品质检测过程,比一般普通网络机顶盒多出整整一倍!另外在拥有业内独家散热通道,散热性能比前代产品提升80%,提升使用寿命。

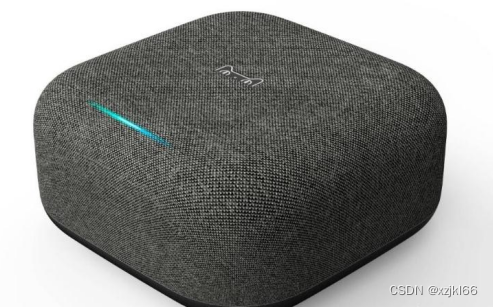

NO.2——天猫魔盒4电视盒子

▶智能音响

天猫精灵隆重推出的新品天猫精灵魔盒也成为天猫魔盒4,它是将AI智能音箱与传统的电视盒子进行了有机结合。三重身份合一,新品类天猫精灵魔盒诞生。

外观设计

从外观上看,这款产品还是有点类似以前的天猫盒子系列产品的方方正正,但是不同于以往磨砂的塑料材质,这次的天猫精灵魔盒的外观采用了一个音箱的设计,正门布满了发声孔,纯灰色的配色,加以正面的天猫logo,形状似立体方块。整体看起来比较有档次,与其他室内家电的配色比较好搭,放在电视旁边也不会显的突兀。

视频体验

天猫魔盒4通过语音交互,能够听懂中文普通话语音指令,可实现智能家居控制、手机充值、叫外卖、音频音乐播放等功能。在资源方面,依托阿里,拥有酷喵的海量资源,应用赋能第三方,囊括音乐、影视、游戏、瑜伽、亲子教育等家庭娱乐的各种场景。同时作为智慧家庭的入口,它还能控制扫地机,空调等设备,真是名副其实的智能管家。

NO.3——小米4S电视盒子

▶支持杜比+ DTS

小米公司的使命是,始终坚持做“感动人心、价格厚道”的好产品,让全球每个人都能享受科技带来的美好生活。

硬件配置

小米盒子4S升级了双频WiFi,WiFi传输速度与稳定性进一步提升。搭载MIUI For TV智能操作系统,提供AV接口、HDMI接口、还提供了USB接口,可插U盘,播放本地视频(支持移动硬盘)。支持4K HDR超高清输出,H.265硬件解码,支持杜比+ DTS, 标配语音遥控器,想看什么,告诉它,立刻就能帮你找到。

视频体验

小米盒子4S内置小米电视的全部内容,不仅有中国互联网和银河互联网电视两大牌照方加持,还与爱奇艺、腾讯视频、搜狐视频、PPTV等视频网站达成合作,从电影、电视剧、综艺、体育、儿童、音乐等在内的所有核心类别内容,都将为用户一一呈现。

NO.4——创维小湃MAX电视盒子

▶丰富资源

创维品牌一向以高品质、高硬件著称,这款创维小湃电视盒子也不例外,硬件做工十分过硬,毕竟也是做电视机出身,有过硬的技术,背后团队实力也不容小觑。

外观设计

首先来说外观,创维小湃MAX电视盒子的外观造型最具辨识度的在于右上角的那一抹红,给整个纯黑机身增加了不少生动的气息。盒子中间是π的图案设计,也是十分简单的风格。接口方面,包括有HDMI口一个,AV 3合1口一个,以及网线LAN口一个,日常看电视足够。

操控体验

创维小湃T3Pro的优势在于它的电视资源更为丰富,支持安装腾讯、爱艺奇、B站、优酷等优质的视频平台应用,热播大剧、综艺、院线大片等等都支持观看。系统可以选择不同的操作模式,比如有老人模式,人性化地推送他们可能喜欢观看地内容,方便操作。

NO.5——海信K3G电视盒子

▶体感游戏

海信虽然是老牌的电视厂商,但是推出的电视盒子打破传统,创新性地加入摄像头以及各种相关应用,增添电视的娱乐属性和应用的智慧性。

外观设计

海信K3G小聚社交魔盒在机身的设计上还是不错的,区别于市场上固有印象的电视盒子设计,采用了一个长条的设计,两边再以圆形作为弧度包边,而且整机都是中轴线对称来展开分布的,比如前置扬声器与摄像头,红外遥控区域与两侧麦克风,状态灯形成的对称,在观感上还是挺舒服的!

操控体验

海信K3G小聚社交魔盒配备了一枚400万像素的大广角镜头,支持人脸追踪、智能跟焦、人脸识别,实现了视频通话、体感游戏以及监控的功能,内置的健身功能还可以智能制定完健身计划,在健身的时候,可以实时对你的动作准确率来进行打分,让运动的姿势更标准,更在健身时增加了一些趣味。

哪个牌子的电视盒子好用?看完电视盒子排名后就知道不同品牌定位是不一样的,大家在挑选时一定要仔细对比后再做决定,找到最适合自己的电视盒子。