绿化信息网站建设那家建网站宝盒好用

**

CCNA-第五篇-基础命令集

**

1.基础命令集

思科设备 : IOS

华为设备: VRP

启动步骤:加电自检-加载系统(IOS/VRP)-运行配置(保留的cfg或者conf文件)

命令行统一称为CLI,CLI是啥呢,命令

简介:CLI一般指命令行界面。命令行界面(英语:command-line interface,缩写:CLI)

连接终端的软件

1.secureCRT

2.Xshell

3.Putty

4.超级终端

一般都使用Console,telnet,ssh(加密的telnet)Secure Shell

学习模拟器

1、EVE

2、ENSP

3、GNS3

4、PT(虽然是官方但是不建议用)

EVE的设备在左下角由一个连接端口号(telnet的)

32679开始(选择基于VM的EVE那个地址)

比如基于VM的EVE上的地址是192.168.1.1 那么打开的第一个设备就是192.168.1.1:32769

在电脑上直接telnet就可以操作这台设备了,也可以通过在浏览器左下角看

ENSP设备是从2000开始的(选择本地环回口127.0.0.1)

后面就2001.2002.2003.2004这样以此类推

**

思科:show体系

**

用户模式Hostname>enable到下面的特权模式

特权模式Hostname#configure terminal 到下面的全局模式

全局模式Hostname(config)#

Hostname(config)#interface e0/1 ///代表进入接口E0/1

TAG:E是ethernet的意思,代表10M连接速率,F开头代表100M,G代表1000M,现在基本上都是G以上的了,因为是用模拟器,所以会有这些旧东西,现在市面上会经常用到光模块,1.25G.10G.25G.40G. 40G叫XG接口,再往上好像有400G的.

接口模式Hostname(config-if)# //进入了E0/1这个接口下,所执行的命令都是为这个接口做配置

Hostname(config)#router ospf 1 ///'启动路由协议OSPF 自治系统编号为1

协议模式Hostname(config-router)# 在这个模式下所执行命令都是为这个路由协议做配置

**

华为:display体系

**

用户模式

系统模式=思科特权+全局【Huawei】

接口模式

协议模式

TAG:不懂的一定要打问号去慢慢找命令,或者用TAB补全,神州数码有中文,但是不建议用。(垃圾神州数码,不是国家扶持早倒闭了)

中国:东8区

Cisco

config下

clock timezone NAME 8(代表东8区)

enable下

clock set 当前时间 月 日

查看:show clock

Huawei

默认窗口下

clokc datetime 时:分:秒 年份 月 日

查看 display clock

TAG:不改时间意味着不同步,不同步就有很多东西是做不了的。还会影响时间策略。行为管理等等。还有查看日志的时候.时间很重要.

安全配置console口的密码

思科:

一种是全部都使用一种秘密(单用户)

一种是单独的用户认证登录(多用户)

思科-单用户

line console 0 ==进入console口

password cisco ==设置秘密为cisco

login ==设置认证

TAG:这种等于单用户,任何人使用console进入都是同一个秘密

华为-单用户

user-interface console 0 ==进入console口

set authentication password cipher huawei == 设置密码为huawei

思科-多用户

line console 0 ==进入console口

login local ==意思是使用本地账户用户登录,所以需要创一个用户

username admin privilege 15 password 0 123456

创一个用户

名字为admin

权限为15

15是最高权限

密码为明文是 0

密码为密文是7

密码为123456

TAG:这样做的用处是什么呢?给不同的用户登录,简单点说就是权限问题。

华为-多用户

aaa 进入3A

local-user admin password cipher admin //创造一个用户账号密码均为admin

user-interface console 0 ==进入console口

authentication-mode aaa ==设置认证模式为aaa认证

什么是3A呢?

AAA是验证、授权和记账(Authentication、Authorization、Accounting )三个英文单词的简称,是一个能够处理用户访问请求的服务器程序,提供验证授权以及帐户服务,主要目的是管理用户访问网络服务器,对具有访问权的用户提供服务。

TAG:简单来说就是认证系统。

单用户做完之后退出到最低再模式进入显示Password就证明对了

多用户做完之后退出到最低再进入模式显示Username就证明对了

TAG:在华为上是默认加密MD5的,那怕你 dis cu 看到的也是加密的

在思科上默认是不加密的,除非打一条系统加固命令,但是这条命令会使此设备上所有秘密变成密文,而且此操作不可逆,只要加密了就无法明文。

Hostname(config)#状态下

Service Password-encryption

翻译:服务密码加密

**

Telnet

**

Cisco

config下

line vty 0 4 //表示允许登陆最大用户为5

password admin //这个虚拟登陆的账户的密码是admin

login local // 开启本地登陆认证,相当于调用本地创建的账户,否则使用上面的admin密码

扩展:登陆後的提示语

执行这条命令注意下,不要在实操环境乱用

transport input none ///禁止所有远程登入

注:none是全部的意思,需要放行什么就放什么,比如放telnet就打telnet.

config下

banner login “hello,word” 这个是登陆界面的

banner exec “hello” 这个是登录后的:

Huawei

user-interface vty 0 4 //表示允许最大的登陆用户为5

authentication mode aaa //设置认证模式为aaa模式

因为这里的环境是根据上面做的,所以会调用上面那个安全console那个地方的那个账户密码,所以此时telnet上来的账号密码是admin/admin

user-interface vty 0 4

protocol inbound all //禁止所有远程登录

跟思科一样,写什么就允许放什么,否则反之

扩展:登陆後的提示语

sysview下

headre login xxx登录界面

hearder shell xxx 登录后

设备升级-USB,FTP/TFTP.CONSOLE,破密码

首先来说个重置设备先,百分百会用到,不要质疑,100%

首先,在思科下,保存,也就是write之后,系统文件以及配置会保存在starup-config下

然后呢,这个starup-config这个东东,是保存在nvram下的

**

SOS

**

思科

首先退出到enable下

然后dir NVRAM:

可以看到有个starup-config的东东

然后erase starup-config 回车就等于确认的意思

然后reload重启即可,直接回车就等于确定

重启后可以看到设备已经恢复到出厂模式,

华为

退出到最底层

然后dir可以看到全部文件配置

然后delete vrpcfg.zip 这个就等于思科的starup-config

删掉之后保存重启就行了

wrirt保存

reboot重启

所以我们也称这个叫跑路命令,慎用!!!

所以我们也称这个叫跑路命令,慎用!!!

所以我们也称这个叫跑路命令,慎用!!!

所以我们也称这个叫跑路命令,慎用!!!

所以我们也称这个叫跑路命令,慎用!!!

所以我们也称这个叫跑路命令,慎用!!!

Linux系统下,跑路命令是rm -rf

别说我教的

别说我教的

别说我教的

别说我教的

别说我教的

别说我教的

别说我教的

别说我教的

别说我教的

**

设备升级(有系统情况下)

**

首先呢,设备升级是在有系统的前提下的,通俗的说就是他能正常运转的前提下

1. FTP/TFTP

首先使用console线连接设备,然后用连接工具去连接设备

一般用什么CRT啊,Xshell,putty啊之类的去连接

连接上之后在电脑的设备管理器去看端口,一般的波特率都是9600/115200

(CRT一定要把流控关了,不然进不去的)

那个RTS/CTS 就是流控

TAG:至于怎么获取上述工具呢,我会重新发一篇文章出来介绍的

第一,路由器交换机这些东西不像windows的iso,去哪都能下载到.一般都是建议去官网下的,不过如果修改过,MD5校验应该也是启动不了的,但是如果要到官网上去下载iso一般都是需要账号的,所以,时升级前首先需要先备份一下源文件,防止升级失败.失败后如果不能复原,那这个设备就算废了.

1.要在本机上搭建一个TFTP/FTP的服务器,最好用FTP,因为FTP是TCP传输,TFTP是UDP传输,但是有些设备是不支持FTP的,至于这个TFTP和FTP怎么搭建和怎么弄,后期会发一遍工具介绍出来的

在enable下

dir 先把.bin文件找出来复制到本机上先

Router#copy xxx:xxxxx.bin ftp: 复制什么路径下的什么文件到FTP服务器中

此时会提示输入IP,然后这个时候输入FTP服务器的地址既可以(前提是搭好了)

然后你会看见一堆叹号在加载,这样的!!!,既可以证明成功

完成后他会自己回到命令行的

2

既然删了底层文件,那如果这个时候保存重启了,那么机器就GG了,懂吧

然后这个时候,当你手上有新的底层文件的时候,要导入进去

enable下

copy ftp或者tftp; flash:

此时他会问你源文件名, 直接复制进去就行

输入後他会问你目的名字,直接回车就行,改也行.

一样的,过程会!!!完成后会自动到命令行.

TAG:不同版本的IOS的命令不一样,所以很多时候建议打问号,这里面只是演示

3

此时一定不能重启先

跟windows一样,你要创造一个指引系统让他去启动这个iso文件

进到config下

boot system 位置://文件名.bin

然后出来保存重启

重启就升级成功了

2. USB

1首先呢,USB接口不是每个机器都有的,而且有的可能进去会无法识别,就电脑上正常设备里面看不到这种情况

2;接入USB会有提示的,usbflash0这样的

然后cd usbflash0:既可以进入

有的时候你会进不去,这个时候是因为格式问题.

路由器应该是识别FAT格式,注意哈 不是FAT32

这个时候 format usbflash0: //意思是格式化词U盘

格式化前记得把资料弄到电脑上先哈!!!

格式化之后没记错应该是FAT格式

从U盘复制到机器上

copy usbflash0: xxx.bin flash: 意思是把这个xx.bin文件复制到flash卡里面

同样的是,不同段版本有不同的命令,不会的时候就打问号看

成功是CCCCC的传输,不是!!!,也一样的.等待即可

传输成功後一样要在config下做系统引导

boot system flash:/xxx.bin

保存重启既可 write

. ***

设备升级(无系统情况下)

假如这个系统崩了,启动显示丢失,这个时候应该怎么办呢?

我们用模拟的环境做一次.

就是删掉iso文件保存重启,那么这个机器肯定起不来

这个就是删掉系统之后重启的画面,肯定的,毋庸置疑.

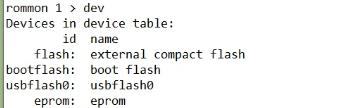

然后这次就不是dir了

而是dev查看

我这里是真机器哈,不是模拟器

由图可以看见

在没系统的情况下,支持flash和usb

这个时候直接从U盘启动系统,就跟电脑没系统的时候用PE一个意思

boot usbflash0:xxx.bin 直接从U盘启动设备

相当于从U盘启动设备,由于是从U盘启动,速度会很慢,等就可以了.

等开机后,就可以从U盘里面复制到本地存储了,不然每次开机都要这个操作,很不方便,总不能每次都带个U盘来开机吧.

copy usbflash0:xx.bin flash:

然后等待,重新建立引导,保存重启即可完成操作!!!

TAG:当有系统,就是可以正常开机使用的时候想进入这个bootrom模式下,可以在开机的时候按住ctrl+break,如果笔记本没有的话可以用win+r,然后osk的虚拟键盘来完成操作

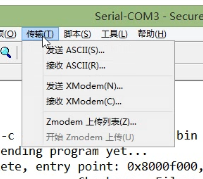

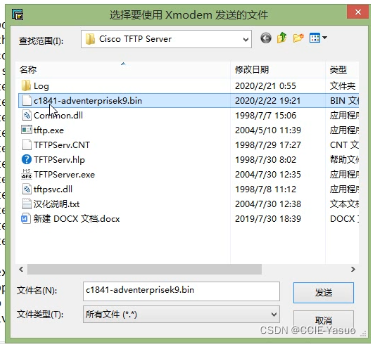

3. Console(Xmodem)

并不是所有的设备都有USB接口的,当然现在绝大多数设备都有.

当没USB的时候,也不能用网线的时候,这个时候就要用到console口了,这个也叫Xmodem协议,任何能配置的网络设备都会有console口的

在bootsystem模式下

xmodem -c xxx,bin 复制这个iso文件到本地存储

然后这个时候你要手动发送这个文件,只要这个东东在你的电脑上就可以了

然后基本上就没啥问题了,失败就基本上就是空间不够,不过一般不会.

但是这个东东是很慢很慢的…所以基本上不到这个情况,还是优先FTP.TFTP.USB,再到console这样.速度会快很多.

各位看官,重头戏来了,破解密码

当不知道console密码的时候,什么也做不了,只能物理断电重启

然后进入bootrom,ctrl+braek

然后我们要修改这个寄存器的值,confreg0x2142(实验模式)

0x2102是正常运行的模式,所以为什么上面的叫实验模式,实验模式是只开机,不加载配置.也就是空配置的意思

直接输入这个confreg 0x2142即可,然后重启就行了,保存都不用

然后这个时候就正常开机了,但是没配置的,show-run就知道了

当来到这,就可以为所欲为啦,空配置的机器.

重新开机可以看到,加载版本为0x2142,而并非2042

这个时候呢,show-run是看不见的,毕竟是空配置嘛,

这时候就要show startup-config来看原始配置

如果密码是明文的话,你爱咋玩咋玩啦,直接登录都行了

如果密码是密文的话,管他呢,直接改不就好啦.

然后这个时候,密码无论你是改了,还是记住了啥,反正你的目的已经达到了

把寄存器的数值改回去,也就是2142改回去2102

config模式下,config-register 0x2102 (这里是直接打的,不能tab补全)

然后show version证实一下,保存重启既可

然后这个时候设备密码就破解成功啦~~~TAG:据我所知,这个东东挺值钱的哈哈哈,听说之前破解密码500/次,那个时候还不像现在有那么多资料,各大网友.加上思科的售后他不像华为那样,对你态度那么好,还一直追着你问好了没好了没.

但是!!咱们吃的技术饭,如果有一天你遇上了这个,你总不能500块5分钟就搞完了,这样甲方会很不爽.你得慢慢搞,起码弄个半小时吧,让甲方感觉这个钱花的值得,你懂吧

IP地址

IP地址是网络世界中最重要的东西,也是最基本的东西

首先,IP这个东西,关乎网络,所以我们说分内外网

内外网的局别在于那呢,在于IP地址的分类.

TAG:IP地址有四类,分别是ABCD,其实往下还有,基本用不到

首先,10段,172段,192段,是用来给内网使用的.所以这些是不可以发上公网的,也发不上去.

然后IP地址中是有分主机位和网络位的

网络位可以随便变动,主机位确定下来了就不可以乱动了

网络位==固定

主机位=不固定

同一个网络位=同一个网段

任何设备,都有一个本地地址=127.0.0.1,有的人叫环回口,有的人叫回环口,知道就行了,Loopback接口.

实际上,127这个段全段都是环回口,因此无论内你在本机上ping任何一个127开头的地址,绝对都是通的.

A类1.0.0.1-126.255.255.254 (最后三位为主机位)

B类:128.0.0.1-191.255.255.254 (最后二位为主机位)

C类:192.0.0.1 - 223.255.255.254 (最后一位为主机位)

D类:多播地址,用来做组播的.比如224.0.0.5=OSPF中的组播地址 IPv4的地址是32位的,4个字节

每个A类地址=2的24次方-2=16777214个地址

每个B类地址=2的16次方-2=65534个地址

每个C类地址=2的8次方-2=254个地址

这个是怎么算的呢,因为A,B,C分别是三,二,一个网络号,一个网络号代表8位,在二进制就是11111111,所以由此计算.-2是因为要掐头去尾

头是网络号,尾是广播地址,

举例:最常见的192.168.1.1 如果192.168.1.0 那么这个代表这个1.0的网段

然后192.168.1.255是这个网段的广播地址

所以,一个C类的网段,一个段里面可以容纳256-2=254台主机,也就是说192.168.1.1-192.168.1.254,这个过程我们叫掐头去尾.大多数人喜欢把1,254,100.这些网络地址当做网关使用.好记

举个例子

A -192.168.1.0 255.255.255.0

B- 192.168.2.0 255.255.255.0

C-192.168.1.0 255.255.0.0

D-192.168.2.0 255.255.0.0

问题:这里上面的IP,有那个是同网段的呢?

答案:C-D

为什么不是AB呢,

因为子网掩码决定了他的网络号和主机号

因为他三个255,网络号是不可以更改的,只有网络号相同的情况下才能算同网段,然而决定网络号的是子网掩码哦

为什么说CD是同网段呢.因为他的掩码是两个255,16位,那就是说,只要他IP的前两端一样,后面无论怎么写他都是同网段

TAG:255.255.255.255=广播地址,ARP广播会用到

TAG:0.0.0.0代表任意网络,以后的路由中肯定会用到这个!

VLSM(可变长子网掩码)

首先呢,这个技术其实不怎么好,也不好学

不是运营商基本上用不到吧.因为从来也是坑自己的

一个完整的IP地址是IP+MASK(子网掩码的)

但是实际上,一般不问掩码多少,除非特别设计的,不问的话默认就是三个255,24位.

但是呢,一个IP地址,最终还是由子网掩码来决定的

哪怕你是1.1.1.1,如果你是24位的,那么一样是一个C类,一个网段只能用253个地址,因为掐头去尾+一个网关就去掉三个了

正常不用VLSM的话就是最小253个地址

但是如果用了,讲真,一旦用,就会浪费地址,最少三个,为什么呢,2的X次方等于可用地址,就拿2的3次方来说,2×2×2=8,去掉网络号第一个,最后一个广播地址,再加一个网关,那么就只有5个地址,那如果说你只要用4个,那不好意思,浪费了.

只有同网段的才能二层通信,不同网段只能三层交换,路由转发

比如,我一个公司,里面需要30电脑+20个服务器

那么我需要的IP地址就是30+20+1+2个地址,1是网关,2是网络号+广播地址,也就是53个

那么就开始算了,2的几次方等于53呢,很显然,没有.

那么往后算啊算,就是2的8次方=64是最接近这个数字的

首先呢,子网掩码,我们能看到的除了0,还有什么128啊,192啊.224.248.252.这些是怎么算的呢?

以上面的条件来解释

用256-64=192,所以这个子网掩码就是192

假设这个IP是192.168.1.0的

那么他掩码如果是255.255.255.192的话

那么他能用的IP地址就是192.168.1-192.168.1.62

这里是62个,加上0和63就是64个

那么多的怎么办呢,浪费呗

所以这个技术其实很鸡肋

但是他也是有好处的,可用减少地址空间以及路由表条目

但是无论好不好用,他就是这样一个规则,所以会用就行了

能用就用子网掩码计算器,机器肯定不会错,这玩意上网搜一大堆